背景

深度学习取得成功的领域主要来源于欧几里得数据(如2维网格的图像和1维序列的文本),但现实生活中还存在大量的非欧几里得数据,如社交网络、电商网络、生物网络和交通网络等。尚未出现对这些数据的有效分析。例如,在电子商务领域,一个基于图的学习系统能够利用用户和产品之间的交互以实现高度精准的推荐。在化学领域,分子被建模为图,新药研发需要测定其生物活性。在论文引用网络中,论文之间通过引用关系互相连接,需要将它们分成不同的类别。

图数据的复杂性对现有机器学习算法提出了重大挑战,因为图数据是不规则的。每张图大小不同、节点无序,一张图中的每个节点都有不同数目的邻近节点,使得一些在图像中容易计算的重要运算(如卷积)不能再直接应用于图。图神经网络(GNN)是一类基于深度学习的处理图域信息的方法。受到深度学习领域进展的驱动,研究人员在设计图神经网络的架构时借鉴了卷积网络、循环网络和深度自编码器的思想。

类别

图神经网络最终分类为:图卷积网络、图注意力网络、图自编码器、图生成网络和图时空网络。这些网络中,图卷积网络在捕捉架构依存关系上扮演着核心角色。

图卷积网络

图卷积网络(GCN)是一个对图数据进行操作的神经网络。对于图 G=(V,E),使用以下特征: 节点特征:每个节点均有其特征,可以用N * E矩阵表示。其中 N 表示节点数,E 表示每个节点的特征数。 图结构特征:图结构上的信息可以用邻接矩阵表示。

卷积网络从卷积方式上可以分为两种:谱卷积和空间域卷积。基于谱的方法通过从图信号处理的角度引入滤波器来定义图卷积,其中图卷积运算被解释为从图信号中去除噪声。基于空间的方法将图卷积表征为聚合来自近邻的特征信息。

图注意力网络

GCN结合邻近节点特征的方式和图的结构相关,这局限了训练所得模型在其他图结构上的泛化能力。而注意力机制能够聚焦于对象最重要的部分,几乎成为序列任务中的标配。该机制在机器翻译和自然语言理解等任务中有着广泛的应用。图注意力网络用注意力机制对邻近节点特征加权求和。邻近节点特征的权重完全取决于节点特征,独立于图结构。

相关模型有图注意力网络(Graph Attention Network,GAT)、门控注意力网络(Gated Attention Network,GAAN)、图注意力模型(Graph Attention Model,GAM)、注意力游走(Attention Walks)。

图自编码器

图自编码器是一类网络嵌入方法,旨在通过神经网络架构将网络中的节点表征到低维向量空间。典型的解决方案是使用多层感知机作为编码器来获取节点嵌入,解码器重建节点的近邻统计。

基于 GCN 的自编码器部分有:图自编码器(Graph Auto-encoder,GAE)、对抗正则化图自编码器(Adversarially Regularized Graph Autoencoder,ARGA)。其他变体包括:具备对抗正则化自编码器的网络表征(Network Representations with Adversarially Regularized Autoencoders,NetRA)、用于图表征的深度神经网络(Deep Neural Networks for Graph Representations,DNGR)、结构化深度网络嵌入(Structural Deep Network Embedding,SDNE)、深度递归网络嵌入(Deep Recursive Network Embedding,DRNE)。

图生成网络

图生成网络的目标是基于一组可观察图来生成图,其中的很多方法都是领域特定的。例如,在分子图生成方面,一些研究将分子图的表征建模为字符串。在自然语言处理中,生成语义图或知识图通常需要一个给定的句子。该领域的方法要么使用 GCN 作为构造块,要么使用不同的架构。

基于 GCN 的图生成网络包括:分子生成对抗网络(Molecular Generative Adversarial Networks,MolGAN)和深度图生成模型(Deep Generative Models of Graphs,DGMG);其他图生成网络有 GraphRNN(通过两级循环神经网络使用深度图生成模型)和 NetGAN(结合 LSTM 和 Wasserstein GAN 从基于随机游走的方法中生成图)。

图时空网络

图时空网络同时捕捉时空图的时间和空间依赖。时空图具备全局图结构,每个节点的输入随着时间而改变。例如在交通网络中,使用每个传感器作为节点来连续记录某条道路的交通流动速度,其中交通网络的边由传感器对之间的距离决定。图时空网络的目标是预测未来节点值或标签,或预测时空图标签。近期研究探索了仅使用 GCN、结合 GCN 和 RNN 或 CNN,以及专用于图结构的循环架构。

基于 GCN 的图时空网络包括:Diffusion Convolutional Recurrent Neural Network (DCRNN)、CNN-GCN、时空 GCN(Spatial Temporal GCN,ST-GCN)。其他图时空网络有 Structural-RNN,一种循环结构化框架。

应用

GNN被广泛应用在社交网络、推荐系统、物理系统、化学分子预测、知识图谱、自然语言处理、计算机视觉(场景图生成、动作识别等)、交通预测等领域。

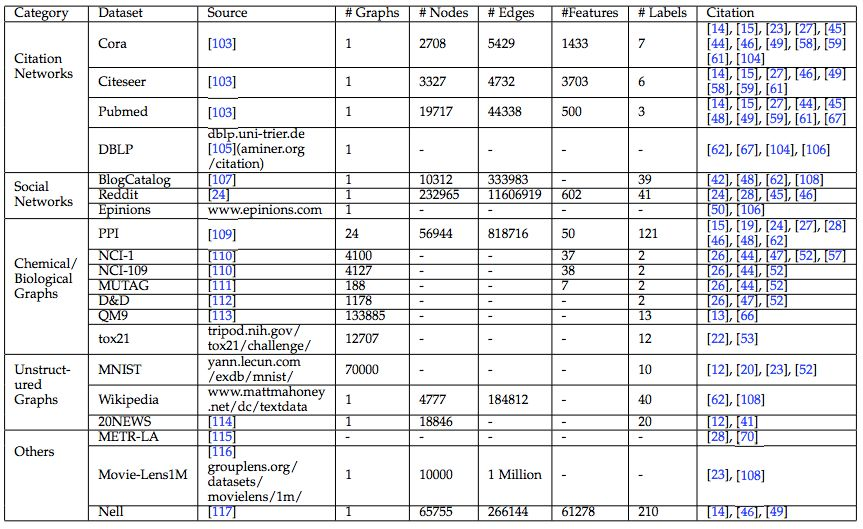

常用的数据集如下:

未来方向

加深网络。深度学习的成功在于深度神经架构。但在图网络中,实证研究表明,随着网络层数增加,模型性能急剧下降。这是由于图卷积的影响,因为它本质上推动相邻节点的表示更加接近彼此。堆叠层数越多,节点考虑的邻居个数也会越多,导致最终所有节点的表示会趋向于一致。这导致了一个问题:加深网络是否仍然是学习图结构数据的好策略?

感受野。节点的感受野是指一组节点,包括中心节点和其近邻节点。有些节点可能只有一个近邻,而有些节点却有数千个近邻。如何选择节点的代表性感受野仍然有待探索。

可扩展性。当前大部分图神经网络并不能很好地扩展到大规模数据(大型图)上。主要原因是当堆叠一个图卷积的多层时,节点的最终状态涉及其大量近邻节点的隐藏状态,导致反向传播变得非常复杂。

动态性和异质性。大多数当前的图神经网络都处理静态同质图,即假设图架构是固定的,而且图的节点和边来自同一个来源。然而,这两个假设在很多情况下是不现实的。在社交网络中,一个新人可能会随时加入,而之前就存在的人也可能退出该社交网络。在推荐系统中,产品可能具有不同的类型,而其输出形式也可能不同,也许是文本,也许是图像。

可解释性。由于图通常与其他学科相关,解释图深度学习模型对于决策问题来说是关键。但是,基于图的深度学习模型比其他黑箱模型更难解释,因为图中的节点和边高度关联。

参考综述论文:

Graph Neural Networks: A Review of Methods and Applications. Jie Zhou, Ganqu Cui, Zhengyan Zhang, Cheng Yang, Zhiyuan Liu, Maosong Sun. 2018.

A Comprehensive Survey on Graph Neural Networks. Zonghan Wu, Shirui Pan, Fengwen Chen, Guodong Long, Chengqi Zhang, Philip S. Yu. 2019.

Deep Learning on Graphs: A Survey. Ziwei Zhang, Peng Cui, Wenwu Zhu. 2018.